Что такое парсинг и когда используют парсеры? Парсинг — что это такое.

Для автоматического сбора нужной информации вам понадобятся специальные программы - парсеры. Сегодняшний выпуск будет посвящен этим инструментам: мы разберемся, что такое парсинг и что такое парсер, увидим их возможности, Вы получите рекомендации по использованию конкретных сервисов и программ.

Что такое парсинг? и Что такое парсер?

Парсинг, он же скраппинг, - это автоматический сбор данных по заданному признаку. В качестве источника может использоваться ваш сайт, другие ресурсы, соцсети. Как правило, эта выборочная информация служит базой для последующего использования. Самый понятный пример - это поисковая система, которая анализирует страницы на релевантность вашему запросу, и выдает только актуальные материалы. Какую информацию можно собрать с помощью парсинга?

- Список товаров, свойств, фотографий, описаний, текстов и т. п.

- Страницы с ошибками (404, отсутствие Title, цены у товара и т. д.).

- Анализ цен у конкурентов, их контент.

- Изучение пользовательской активности на сайте (комментарии, лайки, репосты).

- Сбор аудитории для рекламной кампании и т. д.

Мы сосредоточим свое внимание на бесплатных, недорогих и самых простых инструментах, возможности которых способны помочь в работе над собственным сайтом, (статья «Что такое лендинг»), интернет-магазином или соцсетями.

Инструменты и область применения

Чтобы публикация платного поста в выбранном сообществе была эффективной, есть смысл сравнить аудитории групп. Например, с помощью Publer, где после регистрации вам будет доступен демо-доступ на 5 анализов сообществ в сутки. Полная версия сервиса обойдется в 3000 руб. за месяц, 300 руб. в сутки, при оплате более длительного периода предусмотрены скидки.

Пример работы парсера Publer

Кроме того, вы можете проанализировать сообщество на предмет активности по дням, часам и годам, чтобы подобрать идеальное время для публикаций.

Статистика

Статистика

Парсер картинок (backlinks-checker.dimax.biz) сохранит для вас изображения из Instagram, «ВКонтакте», «Яндекс Картинок», Google Images, Pinterest и других соцсетей. Можно выбрать отдельный пост с несколькими фото (например, галерея Instagram), целый альбом («ВКонтакте» или др.), 1000 последних снимков (стена сообщества). Можно сохранить названия, выбрать фото по «весу» или указать точное количество последних картинок. Платная версия будет стоить от 139 руб. в месяц. Результат - ZIP-файл с картинками:

Парсер картинок и заголовков

Парсер картинок и заголовков

Кроме этого, вы можете спарсить заголовки, описания, ключевые слова любых сайтов, в целях улучшения SEO-показателей собственного ресурса, и подобрать теги для видео на Youtube на основе главного ключевого слова.

Vk.barkov.net - инструмент с наибольшим функционалом для «ВКонтакте» и парсингом по аккаунтам Instagram, Facebook, Skype и Twitter. Можете получить список всех участников сообщества; тех, кто проявил активность; выявить Instagram-профили подписчиков из «ВКонтакте»; отфильтровать пользователей по демографическим и геопоказателям, ключевым словам, времени посещения аккаунта и т. д. Широчайший функционал и must-have для тех, у кого есть сообщество «ВКонтакте», или в планах создание группы в других соцсетях. Стоимость: 399 руб. в месяц, 999 руб. - 3 месяца, и 3999 руб. - за год. Весь функционал сервиса выглядит так:

Интерфейс парсера barkov

Интерфейс парсера barkov

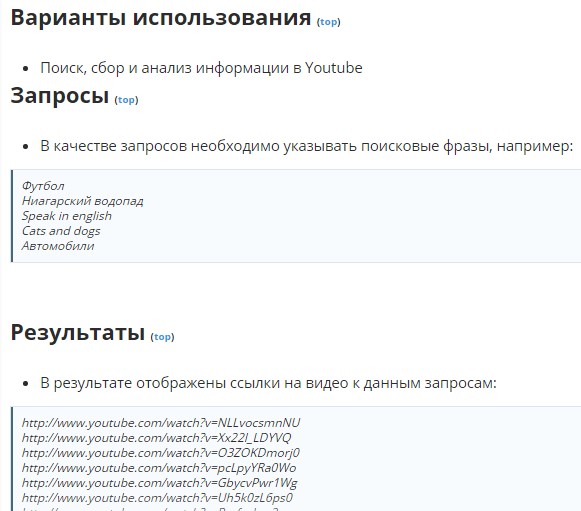

75 различных парсеров разной степени актуальности, в наличии демо-версия на 6 часов (будьте внимательны перед стартом тестирования). Платная версия: от 119$ до 279$. На сайте есть документация с описаниями всех парсеров, примерами результатов и подсказками:

Работа с парсерами — парсинг

Работа с парсерами — парсинг

Также вас может заинтересовать инструмент Datacol, с помощью которого вы можете собирать контент по заданным ключевым словам, парсить интернет-магазины (), лендинг пейдж, для последующего наполнения, собирать e-mail сайтов, «Яндекс.Карты», мониторить цены. Кроме того, вы можете собрать все интересующие объявления по заданной теме, новости, недвижимость, вакансии и резюме, чтобы в результате получить полную базу интересующих вас объектов, необходимых в работе, раскрутке, для в поисковых системах или в личных целях. Так выглядит результат парсера по сбору новостей с News.ru:

Парсер Datacol

Парсер Datacol

Есть также специфичные возможности, которые могут понадобиться при раскрутке определенных компаний и мероприятий. Такая функция и еще несколько полезных критериев, по которым можно искать аудиторию, есть в Target Hunter. Рекомендуем изучить.

Интерфейс Target Hunter

Интерфейс Target Hunter

Для тех, кто не хочет заниматься этим самостоятельно, есть специальная услуга, например, от SMMLemon, которая, по сути, будет результатом того же парсинга. Скорее всего, стоимость использования сервиса будет дешевле заказа услуги. В наличии многоуровневая тарифная система:

Сервис SMMLimon

Сервис SMMLimon

Мониторинг цен и скидок с комментариями для интернет-магазинов, лендинг пейдж предлагает сервис Priceva. Его стоимость уже от 4500 руб. в месяц, а количество проверок доходит до 96 в сутки, что позволяет строго отслеживать цены. Схематичный пример результатов работы сервиса.

Что такое парсинг? Что обозначает это слово, какой процесс под этим подразумевается. У многих новичков при встрече с незнакомыми терминами возникают примерно такие, вполне естественные вопросы.

Мне самому, когда впервые столкнулся с этим термином стало интересно, что же там эти оптимизаторы и вебдизайнеры парсят время от времени. итак перейдем к определению этого термина.

Термин « Парсинг» обозначает проведение визуального или программно-автоматизированного синтаксического и лексического анализа или разбора какого-либо документа с целью извлечения из него необходимых данных.

Это понятие очень близко по значению еще одного не очень понятного человеку далекому от SEO индустрии –

.

Также этот термин близок по смыслу таким понятиям как анализ и аудит.

В применении к SEO, парсинг это сбор информации с какого-то веб-ресурса. Парсить – значит разбирать какой-либо документ на составляющие части и обрабатывать их, согласно конечной цели.

Парсинг данных

Получается, что все процессы, где применяется синтаксический анализ, используют парсинг. Это различные автоматизированные переводчики с одного языка на другой, это и трансляторы языков программирования, которые формируют программный код на машинно-ориентированный язык, это и язык SQL-запросов и тому подобные процессы.

Как нетрудно понять, парсят в подавляющем большинстве случаев при помощи какой-либо программы, так как вручную или визуально это проделывать достаточно трудоемко. Эти программы называют парсерами.

Запросы на услуги парсинга популярны на фриланс-биржах или форумах, посвященных тематике SEO.

Парсинг сайтов

Какие же данные чаще всего получают при помощи парсинга? Это, например, подборка статей определенного автора, или подбор данных на определенную тематику.

Также для анализа часто парсят:

- Выдачу поисковых систем

- Поисковые запросы, семантику

- Информацию по сайтам конкурентов (CMS, структуру, СЯ,…)

- Данные с медиа-ресурсов, различных форумов

- Данных с интернет-магазинов — товаров, цен и т.п.

- И еще много самых различных данных

Это процесс называют парсингом сайтов.

Процесс парсинга в общем случае можно разделить на три этапа:

- Анализ исходных данных, отбор документов для дальнейшей обработки.

- Разбор отобранных документов на составляющие части, выбор необходимой информации и сохранение данных в необходимом формате.

- Систематизация и формирование данных в формате, отчета, таблицы или другого понятного документа.

Приведу простой пример. Например, есть сайт-каталог промышленных компаний. Обработав этот сайт при помощи парсера, можно получить данные в виде отчета или таблицы примерно такого формата:

В СЕО-продвижении парсинг чаще всего используют для получения контента для дальнейшего рерайта или репостинга или для поиска каких-либо веб-ресурсов — форумов, блогов, Email-адресов. Также популярен парсинг внешних ссылок , для анализа сайтов-конкурентов и обнаружения доступных трастовых сайтов.

Все сталкивались с ситуацией, когда нужно собрать и систематизировать большое количество информации. Для стандартных задач по SEO-оптимизации сайта есть готовые сервисы , например, Netpeak Checker — для сравнения показателей конкурирующих сайтов или Netpeak Spider — для парсинга внутренней информации по сайту. Но что, если задача нетривиальна и готовых решений нет? Есть два пути: делать все руками и долго, или загнать рутинный процесс в матрицу, автоматизировать его и получать результат в разы быстрее. О таком кейсе и пойдет речь.

Что такое парсинг сайтов и зачем он нужен

Kimono — мощный и быстрый в настройке скрейпер с интуитивно понятным интерфейсом. Позволяет парсить данные с других сайтов и позже обновлять их. Бесплатный.

Познакомиться поближе и получить краткий мануал об использовании можно (на русском) или на moz.com (на английском). Давайте попробуем спарсить что-нибудь хорошее с помощью Kimono. Например, дополним созданную нами таблицу с городами списком курортов в стране Города 2. Как это можно реализовать при помощи Kimono Labs. Нам понадобятся:

- приложение для Google Chrome — Kimono;

- таблица Google Docs.

1. Находим сайт с необходимой нам информацией — то есть перечнем стран и их курортов. Открываем страницу, откуда необходимо получить данные.

2. Кликаем на иконку Kimono в правом верхнем углу Chrome.

3. Выделяем те части страницы, данные из которых нам необходимо спарсить. Если нужно выделить новый тип данных на той же странице, кликаем на «+» справа от «property 1 » — так указываем Kimono, что эти данные нужно разместить в новом столбце.

4. Кликнув на фигурные скобки <> и выбрав «CSV », можно увидеть, как выбранные данные будут располагаться в таблице.

5. Когда все данные отмечены:

- кликаем «Done » (в правом верхнем углу);

- логинимся в Kimono, чтобы привязать API к своему аккаунту;

- вводим название будущего АРI;

- кликаем «Create API ».

6. Когда API создано, переходим в таблицу Google, куда хотим загрузить выбранные данные. Выбираем «Connect to Kimono » и кликаем на название нашего API — «Resorts ». Список стран и ссылок на страницы с курортными городами выгружается на отдельный лист.

7. Переходим снова на сайт, берем для примера Ирландию, и снова выбираем через Kimono города, которые необходимо спарсить. Создаем API, называем его «Resorts in countries

».

9. В «Crawl Strategy

» выбираем «URLs from source API

». Появляется поле с выпадающим списком всех API. Выбираем созданное нами ранее API «Resorts

» и из него автоматически загружается список URL для парсинга. Кликаем синюю кнопку «Start Crawl

» (начать обход) и следим за статусом парсинга. Kimono обходит страницы, парсит данные по заданному ранее шаблону и добавляет их в таблицу — то есть делает все то же самое, что и для Ирландии, но уже для всех других стран, что ввели автоматически и без нашего участия.

10. Когда таблица сформирована, синхронизируем Kimono Labs с таблицей Google — точно так же, как делали это в шестом пункте. В результате, в таблице появляется второй лист с данными.

Предположим, хотим, чтобы в таблице отображались все курортные города в стране города прибытия. Данные на листах Kimono обрабатываем с помощью формул для таблиц Google, и выводим в строку список городов, где еще можно отдохнуть в Австралии, кроме Сиднея.

Например, это можно сделать так . Разметить массив данных (список городов), используя логические функции и возвращая значение ячейке, равное TRUE или FALSE. На примере ниже выделили для себя города, которые находятся именно в Австралии:

- TRUE = город находится в Австралии;

- FALSE = город находится в другой стране.

По меткам TRUE определяем начало и конец обрабатываемого диапазона, и выводим в строку соответствующие этому диапазону города.

По аналогии можем вывести курортные города и для других стран.

Мы специально привели здесь достаточно простой и пошаговый пример — формулу можно усложнить, например, сделать так, чтобы достаточно было ввести страну в колонку С, а все остальные вычисления и вывод городов в строку происходили автоматически.

Результаты автоматизации

Как говорилось вначале, нам регулярно нужно составлять по 20 однотипных таблиц. Это рутинный процесс, съедающий по 40-50 минут на одну таблицу, и по 16 часов времени на каждые 20 шт. Согласитесь, 2 рабочих дня на одинаковые таблички — необоснованная трата времени. После автоматизации на одну таблицу уходит 5-10 минут, а на 20 — около 2 часов. Таблица имеет 17 ячеек, парсинг производится из 5 источников. Заполнение таблицы происходит автоматически при заполнении всего 2 ячеек с исходными данными.

Настройка и автоматизация парсинга суммарно заняла 30 часов времени, то есть потраченное время «окупится» уже на этапе генерации второй 20-ки таблиц.

В широком смысле слова, парсинг – возможность сопоставлять последовательность слов в предложении с формальными правилами написания отдельного языка. Причем в состав понятия «язык» в этом случае входит обширное множество самых разных смыслов: используется и литературный человеческий язык – любой из тех, на котором каждый день общаются миллионы людей, и любой формализованный язык, например, один из языков программирования.

В вэб-разработке парсинг обозначает последовательную синтаксическую обработку расположенной на страницах сайта информации. Основная часть информации подается на сайтах в виде текста – логических данных с собственной иерархией, определяемой как человеческим, так и языком программирования. Все статьи и тексты, размещенные на сайте, содержат в себе те или иные знания, необходимые пользователям Всемирной Сети. А для того, чтобы страницы сайтов легко читались, используются программные языки, например, JavaScript, HTMLи CSS, используемые в SEO.

Важно различать парсеры и грабберы: если первые способны на обработку найденного контента, то вторые могут только скачать его в свою собственную базу данных.

Что такое парсинг и Предназначение парсинга

При создании нового Интернет-ресурса перед вэб-мастером возникает вопрос наполнения сайта контентом. И для того, чтобы максимально заполнить сайт, многие обращаются за помощью в Интернет, где можно найти любую информацию. Но этот метод не так и прост: владельцу сайта приходится столкнуться с рядом значимых проблем:

- необходимость размещения большого количества информации . Чем больше информации размещено на отдельном сайте, тем больше времени станет проводить на нем рядовой пользователь. Это вынуждает владельцев ресурса размещать на нем немыслимые объемы контента, из-за чего ручное размещение становится затруднительным;

- необходимость в свежей информации . Если большие объемы информации меняются часто, с обновлением информации на сайте не справится даже команда специально обученных сотрудников. В таких случаях смысл ручного обновления контента просто теряется из-за отсутствия физической возможности;

- поиск информации для своего сайта с помощью копирования данных других ресурсов . Зачастую парсинг используют для сателлитов и наполнения сайта простыми элементами, например, отзывами о кинофильмах и кулинарными рецептами. Скопированный фрагмент обрабатывается синонимайзером и рерайтером для того, чтобы повысить уникальность полученного материала.

Именно здесь в игру вступает парсинг ресурсов, способный в автоматическом ежимее собирать, структурировать и изменять информацию. Парсер — это программа, которая осуществляет синтаксический анализ текста. В отличие от человека, программный парсер способен:

- просмотреть и проанализировать тысячи интернет-страниц за ограниченный промежуток времени;

- дифференцировать технические данные и «человеческую» языковую оболочку для информации;

- отобрать нужные данные и отбросить лишнюю «воду»;

- собрать конечные данные в простом и понятном виде.

Результаты работы программа-парсер представляет в виде базы данных, простой таблицы, которая обрабатывается соответствующим образом, или файлом формата XML. Но обработка баз данных не относится к парсингу как таковому. Сам результат парсинга – это ясная структура синтаксиса предложения, которую парсер представляет в формате:

- древа зависимостей;

- древа составляющих;

- комбинированным способом.

Принцип работы парсера

Парсер – это программа, разбитая на три подпрограммы, каждая из которых имеет свои функции и задачи, выполняет различные действия:

- получение информации в ее в исходном виде . Зачастую парсер просто скачивает код страницы, на которой размещены нужные данные, используя при этом библиотеку cURL для PHP;

- выборка и приведение данных к единому формату . С помощью регулярных выражений из скачанного кода извлекаются нужные фрагменты;

- компоновка результата . Завершающая часть процесса парсинга, при которой программа компонует и записывает полученные данные в таблицу или файл.

Язык программирования для написания парсера

Для написания парсера подойдет любой язык, используемый в работе с Интернетом. Зачастую программы-парсеры пишутся на Ruby, PHP, Python, Perl и C++. Язык написания выбирается вэб-мастером в зависимости от цели использования и его собственных возможностей.

Привет, ребят. Опережая события, хочу предупредить, что для того, чтобы парсить сайты необходимо владеть хотя бы php. У меня есть интересная статья о том, . И все же, что такое парсинг?

Начнем с определения. В этой статье речь пойдет о парсинге сайтов. Попробую объяснить как можно проще и доходчивее.

Парсинг, что это значит: слово понятное дело пришло от английского parse -по факту это означает разбор содержимого страницы на отдельные составляющие. Этот процесс происходит автоматически благодаря специальным программам (парсеров).

В пример парсера можно привести поисковые системы. Их роботы буквально считывают информацию с сайтов, хранят данные об их содержимом в своих базах и когда вы вбиваете поисковой запрос они выдают самые подходящие и актуальные сайты.

Кстати говоря, если вы планируете сделать мощное приложение, которое могло бы работать удаленно, то вам может понадобиться аренда dedicated сервера . Это отличный способ получить достаточно мощные ресурсы и нужное количество памяти.

Парсинг? Зачем он нужен?

Представьте себе, что вы , не , а крупный портал с множеством страниц. У Вас есть красивый дизайн, панель управления и возможно даже разделы, которые вы хотите видеть, но где взять информацию для наполнения сайта?

В интернете – где ж еще. Однако не все так просто.

Приведу в пример лишь 2 проблемы при наполнении сайта контентом:

- Серьезный объём информации. Если Вы хотите обойти конкурентов, хотите чтобы Ваш ресурс был популярен и успешен, Вам просто необходимо публиковать огромное количество информации на своем ресурсе. Сегодняшняя тенденция показывает, что контента нужно больше чем возможно заполнить вручную .

- Постоянные обновления. Информацию которая все время меняется и которой как мы уже сказали большие объемы, невозможно обновлять вовремя и обслуживать. Некоторые типы информации меняются ежеминутно и обновлять её руками невозможно и не имеет смысла.

Это самое оптимальное решение, чтобы автоматизировать процесс изменения и сбора контента.

Чем парсинг круче работы человека:

- быстро изучит тысячи сайтов;

- аккуратно отделит нужную информацию от программного кода;

- безошибочно выберет самые сливки и выкинет ненужное;

- эффективно сохранит конечный результат в нужном виде.

Как парсить сайты?

Тут я буду краток, скажу лишь, что для этого можно использовать практически любой язык программированию, который мы используем при разработке сайтов. Это и php, и C++, и python и т.д.

Поскольку наиболее распространенным среди веб-разработчиков является php, я собираюсь написать подробную инструкцию, как можно можно парсить сайты при помощи php или специальных сервисов.

Что такое парсер сайта

Парсер – это скрипт, который вытягивает нужную информацию со сторонних ресурсов.

Парсером может быть как онлайн сервис, так и программное обеспечение, которое устанавливается на компьютер.

Например, я пользовался такой программой, когда нужно было быстро наполнить интернет магазин в 10 000 товаров. Вручную я бы занимался этим целый год наверное. А так справился за неделю.

При установке такого ПО скорость работы во многом зависит от производительности вашего компа. Чем мощнее, тем быстрее происходит процесс обработки данных.

В другом случае, я воспользовался онлайн сервисом, который автоматически брал новости с одного сайта(когда они появлялись) и вставлял их на сайт клиента. Хотя на SEO продвижение такой подход влияет отрицательно. Но, как говорится, желание клиента закон.

Заказать парсинг для сайта/интернет-магазина

Если вам срочно понадобилось настроить парсинг статей на сайт или спарсить товары в магазин, можете оставить заявку и мои программисты за отдельную плату помогут решить эту задачу

Настройка и подключение приставки цифрового телевидения

Настройка и подключение приставки цифрового телевидения Настройка и подключение приставки цифрового телевидения

Настройка и подключение приставки цифрового телевидения Беспроводная акустика JBL GO Black (JBLGOBLK) - Отзывы Внешний вид и элементы управления

Беспроводная акустика JBL GO Black (JBLGOBLK) - Отзывы Внешний вид и элементы управления Виртуальный компьютерный музей Dx связь

Виртуальный компьютерный музей Dx связь